近日,以诚为本赢在信誉9001cc研究成果“EntropyStop:Unsupervised Deep Outlier Detection with Loss Entropy”在CCF-A类数据挖掘领域顶级国际会议ACM KDD 2024(Knowledge Discovery and Data Mining)的Research Track发表。论文第一作者为学院2021级硕士研究生黄逸宏,第二作者为2022级硕士研究生张宇昂,通讯作者为指导老师王丽苹。以诚为本赢在信誉9001cc为论文的第一作者和通讯作者单位。

本次会议在西班牙巴塞罗那举办,黄逸宏受邀参会并做口头报告。

▲ 论文的基本信息

▲ 论文第一作者黄逸宏受邀参会并做口头报告

成果介绍

随着深度学习技术的不断发展,异常检测(Outlier Detection,OD)在处理大量复杂数据时变得愈发重要。传统的无监督异常检测方法通常要求在干净数据集(Clean Dataset)上进行训练,以确保模型能够准确学习正常数据的分布,从而检测出异常。然而,获取大规模的干净数据集往往需要大量的人工干预,这与无监督学习的目标相悖。特别是在实际应用中,采集的数据往往包含噪声或异常样本,直接在上述无标签混合数据集(Contaminated Dataset)上进行异常检测模型训练面临着由于缺乏标签信息,无法确定深度学习模型的收敛状态,深度异常检测模型的性能很难达到预期效果的挑战。

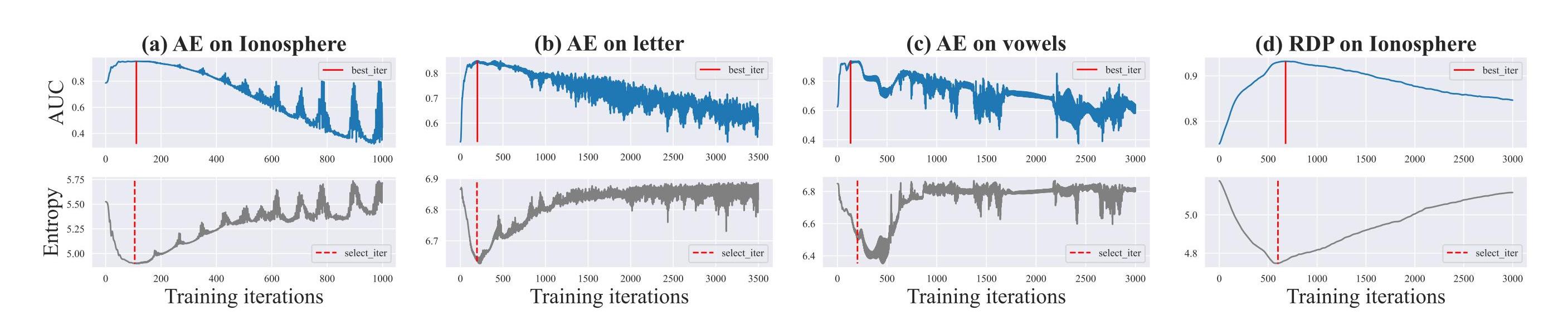

针对上述难题,论文作者发现了无标签混合数据集在训练阶段内部评估的新指标——损失熵,基于此提出了一种新颖的基于损失熵的深度异常检测模型的自动训练早停方法EntropyStop。该算法可以在异常检测模型性能开始下降之前自动停止训练,从而提高训练效率并避免模型性能退化。作者从理论上证明了损失熵对于无标签混合数据集训练的重要意义,同时也在ADBench上的47个真实数据集上进行广泛的实验。实验结果表明,EntropyStop增强的自编码器(AE)不仅在性能上超越了SOTA的集成AE模型,而且总的训练时间不到原有模型的5%。此外,作者还在论文中验证了损失熵和EntropyStop在其它深度OD模型上的广泛适用潜力。

▲ 论文中EntropyStop算法的训练效果图

KDD是数据挖掘和知识发现领域影响力最高的顶级国际会议,由ACM(美国计算机协会)主办,以其严格的审稿标准和高质量的研究成果闻名,被CCF(中国计算机学会)推荐为A类国际顶级会议。本次会议采用OpenReview平台进行双盲评审,Research Track的论文录用率仅约20%。